Article tagué recherche

Retour d’effort sur écran tactile : de la vibration au tixel

20/07/11

свети атанасUn utilisateur de tablette, smartphone ou autre terminal mobile à écran tactile a besoin de savoir si sa machine a bien comprit qu’il vient d’appuyer sur un bouton virtuel affiché à l’écran. Les concepteurs d’interfaces utilisent principalement deux méthodes (cumulables) pour donner ce retour d’information (feedback) :

• Le retour d’effort : en faisant vibrer tout le terminal pour symboliser la pression d’une partie de l’écran. C’est facile à mettre en œuvre, ça marche assez bien. Mais c’est limité à une pression à la fois (pas de multitouch) et c’est un retour très binaire (qu’on effleure ou qu’on frappe son écran, seule la durée de vibration peut varier, pas vraiment son intensité. )

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

Pour le son, on utilise essentiellement des « clics » qui rappellent l’usage d’un bon vieux clavier ou d’une souris

Pour le visuels, les effets courant sont

- l’illumination : un halo lumineux indique l’activation de la touche.

- l’ombrages : pour pousser la métaphore de l’enfoncement.

- la délocalisation de la touche (mini pop up) qui permet d’afficher la touche pressée alors qu’elle est occultée par le doigt de l’utilisateur (pour une fois un sort de la métaphore pour entrer dans l’idiomatique http://www.multimedialab.be/doc/alan_cooper.htm)

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

L’avantage de se passer des vibrations mécanique, c’est de pouvoir localiser l’effet (on ne fait plus vibrer la totalité de l’appareil) et d’éviter la perturbation sonore crée par un moteur.

Le dispositif utilise des minuscules céllules nommées tixel (pour « tactile pixels ») qui génères des champs électriques. L’intensité de chaque tixel est contrôlable, ainsi à l’instar des pixels qui génèrent une image, les tixel génèrent une texture dynamique que l’on ressent passant le doigt sur la surface.

Quand on examine de plus près la description que fait Senseg de son produit on peut lire que les champs magnétiques « s’étendent sur plusieurs millimètres au-dessus de surface de l’appareil ». Ce qui offre la possibilité de donner des sensations tactiles lors du survol d’une zone.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Si vous passez à Helsinki ou Tokyo, vous pouvez contacter Senseg pour tester le dispositif.

Source : springwise

Utiliser la peau comme interface d’interaction

10/03/11

Le projet “Skinput” dévoilé par Microsoft Research vise à faire de notre bras une véritable télécommande numérique. Le principe est simple : quand on le tapote son avant-bras avec un doigt, il subit une mini onde de choc qui se propage le long du bras.

L’équipe du Human Computer Interaction Institute a développé un bracelet qui s’enfile comme un tensiomètre et capte ces ondes de choc. En analysant les réactions aux tapotements sur la peau, il est possible d’utiliser le bras comme interface d’entrée pour le contrôle de machines. Coupler cette interface naturelle avec un (pico)projecteur permet de transformer sa peau en écran tactile.

La miniaturisation de l’électronique pourra trouver un fort intérêt à limiter la taille des interfaces d’entrée et utiliser des surfaces existante comme “input”, une table, un mur… c’est d’ailleur l’objet de cet autre projet de la recherche Microsoft : Light Space

Le réel augmenté d’un sixième sens numérique

25/03/09

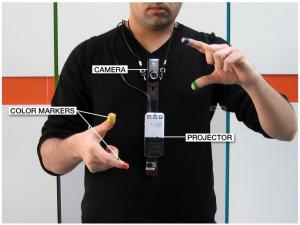

Pranav Mistry, assistant de recherche du Groupe des interfaces fluides du Massachusetts Institute of Technology (MIT) a encore fait sensation avec son nouveau projet présenté par sa directrice de labo Pattie Maes, lors de la conférence TED de PalmSprings en février.

Pour mémoire, Pranav Mistry était l’auteur des post-it nouvelle génération nommés « Quickies » qui ont trouvé un large écho sur le web l’an passé.

Le projet au nom de code « WUW » a été rebaptisé « Sixthsense » pour sa sortie du labo. Cette fois, l’utilisateur n’est pas dans son bureau, il est invité à bénéficier des données disponibles sur internet dans leur quotidien, et ce, sans périphérique spécifique.

Le concept est presque simple, il allie une caméra visualisant à peu près la même chose que son porteur, un (nano) vidéoprojecteur et quatre marqueurs de quatre couleurs pour pouce et index.

La vraie innovation est de proposer une nouvelle alternative aux deux grandes façons de faire de la réalité augmentée :

• Porter des lunettes spécifiques qui sont en fait des écrans semi-transparents où sont affichées des formes ou informations. Cette (vielle) méthode ayant fâcheusement tendance à créer des maux de tête à force de demander aux yeux de faire la netteté à deux distance à la fois (le verre des lunettes très près des yeux et l’environnement plus éloigné).

• voir l’environnement réel à travers un écran qui diffuse la vidéo prise par la caméra, à laquelle s’ajoute les éléments virtuels. (Rappelez-vous du projet MARA de Nokia ou plus récemment du portage de l’API AR toolkit sur iPhone).

Cette fois, on ajoute des infos sur les objets de l’environnement eux-même ; bien sûr il faut des surfaces de projections adaptées (il vaut mieux avoir un ami avec un T-shirt blanc).

Les fonctions développées sont relativement classiques (celles que les adeptes de la réalité augmentée imaginent depuis longtemps) avec en plus des idées empruntées au monde des périphériques mobiles (avoir tous types d’informations partout tous le temps.)

Une petite vidéo vaut mieux qu’une grande description :

Plus d’informations : http://www.pranavmistry.com/projects/sixthsense/index.htm

Sisi vous le dis avec ses mains.

6/11/07

L’université d’East Anglia (royaume unis) et IBM ont communiqué en septembre dernier sur le projet qu’ils ont développé en commun. L’aboutissement de ce projet est une application qui traduit les paroles en langages des signes et qu a pour nom de code SiSi pour « Say It Sign It ».

Avatar féminin ou masculin – en démonstration vidéo ici

L’application comporte plusieurs modules mis bout a bout pour produite l’effet souhaité : Un module de reconnaissance vocale que transforme la voix en texte, un module qui transforme le texte en signes et un module qui fait effectuer ces signes à un avatar 3D. Certaines personnes commentant ce communiqué soulignent, que le visage non expressif du personnage doit affecter la compréhension.

Cette idée de traducteur virtuel automatique répond au chercheur Mexicain Jose Hernandez-Rebollar de la George Washington University. Il avait crée en 2000 un dispositif, l’ acceleglove, qui permette de traduire à travers d’un synthétiseur vocal ce qu’une personne exprimait en langage des signes.

Sources : http://www-03.ibm.com/press/us/en/pressrelease/22316.wss

Plus d’infos sur l’ acceleglove : www.seas.gwu.edu/~gogo/papers/hernandez_SIGGRAPH_2002.pdf

Connecting Virtual People

7/05/07

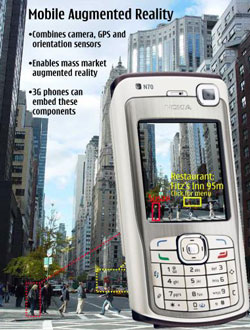

L’équipe de recherche de Nokia en Finlande ayant mis sur pied le projet MARA (Mobile Augmented Reality Applications) dont je vous parlais fin 2006 a cessé de travailler sur ces technologies. La firme mondiale a passé le relais à une équipe du nouveau centre de recherche Nokia basé à Palo Alto aux Etats Unis. L’équipe de développement des applications de réalité Augmenté compte Kari Pulli et Radek Grzeszczuk. Ces deux noms indiquent le tournant qu’est en train de prendre Nokia pour ses applications mobiles futur : ces chercheurs sont des spécialistes du rendu 3D temps réel et de la reconstruction géométrique à partir de texture.

L’équipe de recherche de Nokia en Finlande ayant mis sur pied le projet MARA (Mobile Augmented Reality Applications) dont je vous parlais fin 2006 a cessé de travailler sur ces technologies. La firme mondiale a passé le relais à une équipe du nouveau centre de recherche Nokia basé à Palo Alto aux Etats Unis. L’équipe de développement des applications de réalité Augmenté compte Kari Pulli et Radek Grzeszczuk. Ces deux noms indiquent le tournant qu’est en train de prendre Nokia pour ses applications mobiles futur : ces chercheurs sont des spécialistes du rendu 3D temps réel et de la reconstruction géométrique à partir de texture.

Ces compétences mis en commun au service de la réalité augmentée embarquée nous permet d’imaginer une jolie suite au projet MARA. Pour l’exprimer avec des mots simples, disons que les téléphones ne se contenteront pas d’afficher des informations textuelles par-dessus une vidéo, mais seront, par exemple, capables d’afficher une modélisation 3D de monument ou encore d’analyser ce qui est vu par la caméra du téléphone et le transformer en objet 3D (scanner 3D de poche).

En extrapolant, ce peut être le début du chat via avatar 3D interposé, le décollage jeux pervasifs (mise en situation réelle des joueurs), les VMS (virtual messaging service) ou l’ont enverra des messages accompagnés d’objets 3d…

Alors, à quand les mobiles à double caméra et les écrans reliefs. Pas forcément dans si longtemps, le futur commence dès demain.

Source : Markus Kähäri, project manager of MARA Project

MARA, et voilà, la RA est là !

30/11/06

Comme je l’énonçais il y a quelques mois, le téléphone portable joue son rôle de catalyseur pour l’arrivée de la Réalité virtuelle et augmentée auprès du grand public. Nokia, le colosse finlandais de la téléphonie, viens de publier des résultat de son service R & D. Le fruit du labeur est une application nomée MARA (pour Mobile Augmented Reality Applications) dont le but est d’identifier des objets ou des bâtiments vus à travers l’écran d’untéléphone mobile. Bien sur, il faut un téléphone adapté pour que le logiciel puisse ajouter des informations sur une vidéo capturée en temps réel par la caméra intégrée du portable.

Comme je l’énonçais il y a quelques mois, le téléphone portable joue son rôle de catalyseur pour l’arrivée de la Réalité virtuelle et augmentée auprès du grand public. Nokia, le colosse finlandais de la téléphonie, viens de publier des résultat de son service R & D. Le fruit du labeur est une application nomée MARA (pour Mobile Augmented Reality Applications) dont le but est d’identifier des objets ou des bâtiments vus à travers l’écran d’untéléphone mobile. Bien sur, il faut un téléphone adapté pour que le logiciel puisse ajouter des informations sur une vidéo capturée en temps réel par la caméra intégrée du portable.

Les outils nécessaires sont un GPS, un accéléromètre et un Gyroscope intégrés. Après, c’est une base de donnée de géolocalisation qui fait le reste, proposant à la façon de liens hypertexte des info sur les bâtiments reconnus.

La fonction « friend finder » permet même de retrouver un ami qui utilise le même système. En extrapolant on pourrait envisager de lire le CV ou accéder au blog d’une personne que l’on croise dans la rue…

La fonction « friend finder » permet même de retrouver un ami qui utilise le même système. En extrapolant on pourrait envisager de lire le CV ou accéder au blog d’une personne que l’on croise dans la rue…

Touche-moi que je sache qui tu es !

31/05/06

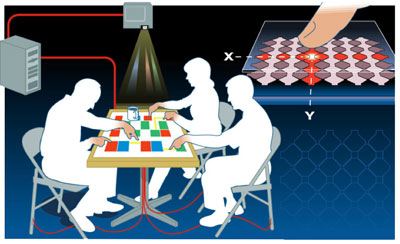

L’écran tactile, c’est bon, on connait (un doigt, un utilisateur), l’écran tactile multitouche aussi (plusieurs doigts, un utilisateur), mais comment on fait quand on est plus que un a avoir pleins de doigts ?

Une solution est proposée par les ingénieurs de MERL (Mitsubishi Electric Resarch Laboratories), et elle se nomme DiamondTouch. La technique est assez simple, chaque utilisateur est équipé d’un récepteur. Lorsqu’un doigt entre en contact avec l’écran, le signal électrique approprié circule via le corps du propriétaire jusqu’au récepteur. Un signal par personne, on sait donc qui touche où…

Écran Tactile Multi-Touch

19/03/06

Qui aurait penser demander un jour à son écran : Combien j’ai de doigts ? et que celui ci lui réponde au doigt et à l’oeil.

Tremblez de plaisir braves gents, voici le résultat du labo Multi-Touch Interaction Research , un écran tactile qui reconnais la pression simultanée des 10 doigts et sait reconnaître un index d’un majeur… Encore une fois je vous conseille la vidéo de démo, c’est bluffant.

Reste à savoir quand on pourra utiliser ce genre de technologie et imaginer tout ce que l’on peut faire avec…