L’avenir des IHM : surface tactile ou analyse vidéo ?

Chez Microsoft Research, on travail sur différentes thématiques liés au interfaces humains machines. Je vous avais parlé il y a quelques mois dans ce billet de l’usage de la peau comme surface d’interaction, en ce début d’automne, ce sont deux nouveaux projets dévoilés par le centre de recherche de la firme de Redmond : OmniTouch et PocketTouch Les deux projet prennent en compte la notion de mobilité.

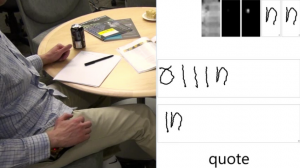

Le premier projet est basé sur la vision par ordinateur (computer vision) consiste à utiliser un vidéoprojecteur affichant une image qui est analysée par un capteur qui détecte les mouvements de l’utilisateur. C’est une interprétation du projet 6th Sens en utilisant le savoir faire de la Kinect pour obtenir une information de profondeur et savoir si le doigt touche ou non la surface d’affichage.

Le premier projet est basé sur la vision par ordinateur (computer vision) consiste à utiliser un vidéoprojecteur affichant une image qui est analysée par un capteur qui détecte les mouvements de l’utilisateur. C’est une interprétation du projet 6th Sens en utilisant le savoir faire de la Kinect pour obtenir une information de profondeur et savoir si le doigt touche ou non la surface d’affichage.

Le second projet Utilise un capteur tactile capacitif pour détecter des gestuelles à travers un textile. Le principe étant de piloter des fonctionnalités d’un mobile alors que celui ci est dans sa poche.

La calibration est différente selon le type de tissus utilisés, mais l’application pourrait donner des pistes intéressantes.

Plus d’infos sur le site de Chris Harrison (également à l’origine du projet SkinPut)

• OmniTouch

• PocketTouch

| Cette entrée a été posté par Florent_MICHEL le 19 octobre 2011 à 13:47, et placée dans Billets, Ergonomie & IHM, Ma_Recherche, Réalité Virtuelle. Vous pouvez suivre les réponses à cette entrée via RSS 2.0. Vous pouvez laisser une réponse, ou bien un trackback depuis votre site. |